Hace unos días se ha estrenado [REC] 2, la secuela de la fantástica [REC] de Jaume Balagueró y Paco Plaza. El argumento es bien conocido: los habitantes de un bloque de viviendas (junto con un par de policias, un par de bomberos y un par de reporteros) deben enfrentarse al estallido de una infección zombi (usando el término «zombi» en sentido amplio). La película es interesante por múltiples motivos, pero vamos a centrarnos en dos aspectos particulares: (1) el edificio está aislado en cuarentena por las autoridades sanitarias, y (2) el equilibrio de fuerzas dentro del edificio va volcándose paulatinamente del lado de los infectados. Estos dos aspectos nos conducen a dos cuestiones fundamentales: la primera en relación con el punto (1) es si la estrategia de las autoridades sanitarias es correcta, y la segunda en relación al punto (2) es si la evolución del sistema hacia el desequilibrio mostrado en la película es realmente inevitable. Se trata de dos cuestiones que aparte de ser interesantes desde el punto de vista geek/nerd, constituyen un buen experimento mental con posibles aplicaciones a infecciones de carácter más mundano.

![[REC] [REC]](https://singularidad.files.wordpress.com/2009/10/rec.jpg?w=450&h=350)

Dar respuesta a estas cuestiones requiere modelar el problema como un sistema dinámico, de manera similar a como se realiza en ecología, epidemiología, etc. y ver cómo evoluciona en el tiempo. Un análisis de estas características es precisamente el realizado por Philip Munz y colaboradores, de la Carleton University y de la Universidad de Ottawa, en un trabajo que lleva por título:

y que forma parte del libro Infectious Disease Modelling Research Progress, editado por J.M. Tchuenche y colaboradores en Nova Science. Munz et al. consideran varios modelos de complejidad cada vez mayor para estudiar el sistema. En el primero y más básico se consideran tres tipos de sujetos:

- Los seres humanos «normales», susceptibles (s) de convertirse en zombies.

- Los zombis (z).

- Los sujetos «retirados» (r), esto es, seres humanos que mueren por causa natural.

Inicialmente se parte de una población de sujetos susceptibles, sin zombis ni retirados, y a partir de ahí se produce un flujo de sujetos de una a otra categoría:

- Un ser humano puede nacer (con tasa π), morir de causa natural y pasar a retirado (con tasa δ), o convertirse en zombi tras ser atacado por uno de estos (con tasa β, y proporcional a la población de zombis).

- Un zombi puede pasar a retirado si un humano lo vence en un enfrentamiento (con tasa α).

- Un sujeto retirado puede convertirse en zombi (con tasa ς).

Esto nos lleva a un sistemas de ecuaciones diferenciales que describe el sistema:

Si se analiza el sistema de ecuaciones en una escala de tiempo muy corta en la que no se llegan a producir nacimientos ni muertes naturales (π=δ=0), la primera ecuación diferencial sugiere dos posibles estados estacionarios (S,Z,R): el primero (S,0,0) es aquel en el que no hay zombis; el segundo (0,Z,0) es el apocalipsis zombie (toda la población acaba infectada). Lamentablemente el análisis del Jacobiano del sistema en estos puntos estacionarios indica que la primera solución no es estable, pero la segunda sí, por lo que basta un pequeño empujón para que el sistema ruede cuesta abajo hacia el apocalipsis zombi.

Hay algún aspecto cuestionable en el sistema anterior, como por ejemplo el hecho de que los zombis destruidos pasen a la categoría de retirados y puedan «reciclarse» en zombis de nuevo. Si eliminamos el término αsz de la tercera ecuación no alteramos sin embargo el resultado anterior, al menos desde el punto de vista cualitativo. No obstante, vamos a tener en cuenta esta modificación del modelo de Munz et al. en lo sucesivo.

Para acercarnos más [REC] el siguiente paso es considerar ahora un modelo de infección latente. Munz et al. modelan esto como una nueva clase -infectados (i)- a la que llegan los susceptibles que son mordidos por un zombie, y de la que salen aquellos infectados que se transforman en zombis (con tasa ρ), y aquéllos que mueren antes de transformarse (con tasa δ, como los susceptibles). Con la modificación mencionada antes en relación a los «retirados» nos queda:

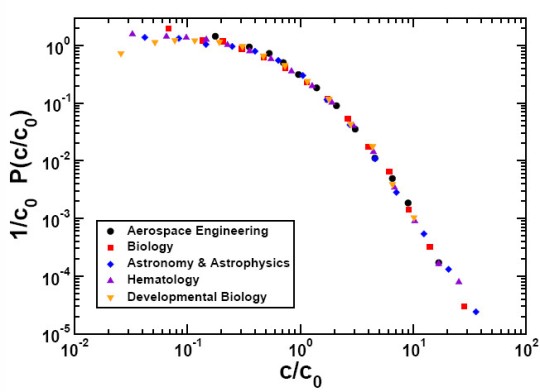

En este escenario la situación es idéntica en el escenario π=δ=0, esto es, no pueden coexistir humanos y zombies, y sólo el apocalipsis zombi es una solución estable. Si realizamos una simulación numérica puede apreciarse el comportamiento cuantitativo del sistema. La siguiente gráfica corresponde a los parámetros π=δ=1/10 000 (tasas iguales de nacimiento y muerte natural), ς= 1/10 000 (tasa de zombificación de retirados), α=1/200 (tasa de destrucción de zombies), β=1/100 (tasa de infección), y ρ=1/200 (tasa de zombificación de infectados):

Nótese como el número de zombis libres es durante la fase inicial del estallido muy bajo, aunque suficiente para inducir una infección latente descontrolada. Eventualmente el número de individuos sanos cae abruptamente, momento en el que el número de infectados deja de crecer y comienza el apocalipsis zombi, ya sin humanos sanos para hacerles frente. Una variante de este modelo es asumir que los infectados permanecen activos en la población, teniendo encuentros con los zombis y contribuyendo a su erradicación mientras no se consume la transformación. En ese caso, el resultado final sigue siendo un apocalipsis zombi, aunque más tardío, y con un número final de zombis mucho más bajo.

Introduzcamos ahora el siguiente factor de [REC], la cuarentena. Munz et al. modelan una nueva clase -cuarentena (q)- a la que llegan tanto sujetos infectados como zombis, y de la que salen únicamente los sujetos que intentan escapar y son eliminados, pasando a la categoría de retirados. Vamos a modificar esto ligeramente, suponiendo que la cuarentena efectivamente retira de la circulación a los sujetos aislados (vivos, muertos o infectados), sin posibilidad de que vuelvan a la categoría de retirados.

Incluso en este caso, el apocalipsis zombi es prácticamente inevitable, si bien la cuarentena puede retrasar bastante el progreso de la infección. Munz et al. consideran un modelo adicional en el que es posible curar (pero no vacunar) a los zombis, y en este caso se alcanzan situaciones de equilibrio en las que coexisten zombis y humanos sanos (no es un escenario agradable, pero es mejor que el apocalíptico).

Sea como fuere, e incluso sin cura, podría haber otro tipo de estrategias ganadoras. Una de las claves de las simulaciones es el equilibrio demográfico de la población sana. En el momento en el que se comienza a producir la infección empieza el descenso de individuos sanos y tarde o temprano tiene lugar el apocalipsis zombi. Aumentar la tasa de nacimientos retrasa el proceso pero no lo evita. Para ello es preciso combinar un aumento de esta tasa de nacimientos con aumento de la tasa de destrucción de zombies. Bebés y lanzallamas, es una receta que nunca falla.

![[REC] [REC]](https://singularidad.files.wordpress.com/2009/10/rec.jpg?w=450&h=350)